みなさま、明けましておめでとうございます! 新年一発目は新しいことやろうとしていたので、ずっとやりたかったSlackで必要なことを1つにまとめるTipsについてです。

昨年のこちらの記事に触発されたこともあるので、ZapierでSlackにスケジュールとRSSフィードをまとめます。

[偉大な参考記事] tech.mercari.com

[Zapier公式] zapier.com

やること

- 散漫になってウォッチしづらかったものをSlackに送りつける。

- Googleカレンダーをポストする

- RSSフィード(購読中のはてなブログ)から更新をポストする。

Zapierって?

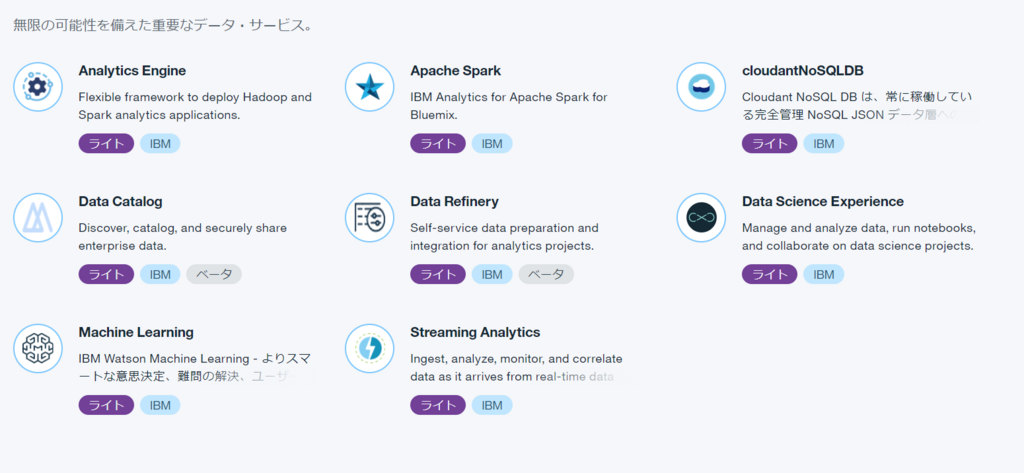

よく使うツールを繋ぎ合わせて、一連の作業を自動化するツール。一連の作業はZapとして作成します。 スクショの通り、めちゃくちゃいろんなツールが使えます。 例えば、Google DriveにファイルがアップロードされたらSlackに通知するとか、GithubのissuesをTrelloカードに追加したりできます。 Exploerタブからツールを選べば、10,000以上のZap例が出てくるのでみて見ると夢が膨らみます。

- Slack

- Google Calendar

- Google Drive

- Office365

- Evernote

- GIthub

- Zapier組み込みツール(RSSフィード / メール / SMS etc...)

サクッと作る

早速作ります。Exploerタブから使いたいツールを選択すると、よく作られるZapの一覧が下に出てきます。

自前で作ることもできるようですが、だいたい作るZapは定型化されているので Use this Zap から使わせてもらいましょう!

あとはガイドに沿ってプルダウンやら項目を埋めれば5分経たずに作成できます。ヽ(*´∀`)人(´∀`*)ノ

他にも、はてなブログのメール通知だと見逃す購読中のブログの更新(RSSフィード)もポストしたりできまする。 見るべきところを1つにまとめられると楽ですね。

1つのツール内でもトリガーやアクションは選べるようで、アクションの条件もフィルタリングできるようです。 例えば、Google Calenderのイベントの内容に[準備] が含まれているときだけ通知とか。

他にも使えそうなツールがたくさんあるようなので、自分の手持ちのツールのintegrationをみて見るといいかもしれないですね。